Warum hat Apple mit Lisa und Macintosh und Newton zunächst Flops produziert? Warum wurden diese Produkte später so erfolgreich, zum Teil in anderer Gestalt? Was sagt das über das iPad und andere Tablets aus?

Im Nachhinein lassen sich viele Entwicklungen gut und kompetent erklären. Wenn man mittendrin steckt, fällt das schwer und ist meist nur Raten. Doch wie schon Annie in Zak McKracken wusste: „Das Wissen über unsere Vergangenheit bringt uns eine bessere Zukunft.“ Untersuchungen von Gesetzmäßigkeiten aus der Vergangenheit helfen, aktuelle Vorgänge besser zu verstehen. Wendet man sie auf andere als die untersuchten Gegenstände an, dann erscheinen bestimmte Phänomene plötzlich plausibel.

Zum besseren Verständnis der vorgestellten Idee folgt zunächst ein kleiner Exkurs zur Veranschaulichung, bevor ich zu den eigentlichen Fragen zurückkehre.Eine solche Theorie wurde von „Windermere Associates of San Francisco“ aufgestellt und unter dem Namen „Buying Hierarchy“ aufgestellt. Deren Produkt-Evolutions-Modell basiert auf vier Phasen:

- Funktionalität (functionality)

- Zuverlässigkeit (reliability)

- Bequemlichkeit/Komfort (convenience)

- Preis (price).

Auf diese Theorie verweist Clayton M. Christensen in seinem Buch „The Innovator’s Dilemma“, in dem er untersucht, wieso erfolgreiche Unternehmen an sogenannten „disruptive“ Entwicklungen scheitern. „Disruptive“ lässt sich schwer übersetzen, Guy Kawasaki bezeichnet den Vorgang als „Jumping the Curve“. Es bedeutet im Gegensatz zur Produktevolution eine Produktrevolution. Für Versand-Unternehmen ist der Online-Handel – zumindest theoretisch – nur eine Erweiterung des Versandkanals, es müssen kaum Unternehmensprozesse angepasst werden, nur ein weiterer Handelskanal wird hinzugefügt, für den Produktinformationen aufzubereiten und der Bestellkanal einzurichten sind. Versandunternehmen verfügen mit Katalogen, Bestell-Hotlines und ihrer Logistik über alles benötigte Know-how. Für den Einzelhandel dagegen ist der Online-Handel eine „disruptive“ Evolution, denn die wenigsten ihrer Prozesse (von Lager über Logistik bis Bestellwesen) ist für diesen Kanal vorbereitet. Insbesondere für Handelsketten war diese Entwicklung teilweise herausfordernd, denn es besteht ein Unterschied zwischen der Logistik für ein Filialnetz und der Logistik für die Belieferung an Endkunden. Auch die Bestellwege änderten sich: Neben den Filialen kann jeder Endverbraucher direkt bestellen. Somit ist die Unterscheidung zwischen „disruptive“ und „sustaining“ (= bewahrenden, evolutionären) Entwicklungen vom Kontext und der Perspektive abhängig und gilt nicht pauschal für alle.

Mit einem „disruptive“ Produkt beginnen die Vier-Phasen jedes Mal neu. Am Beispiel der Auto-Industrie lässt sich das grob skizzieren.

Die vier Phasen der Auto-Entwicklung

1. Funktionalität

Es gibt ein neues Produkt, das für Kunden interessant ist. Es sind keine Pferde nötig, der Fahrer kann sein Ziel selbstbestimmt erreichen. Diese Funktionalität ist interessant, und alle Kunden, die diese Funktionalität benötigen, wollen diese kaufen. Jedoch ist das Wissen um die Vorteile noch nicht so breit ausgeprägt, sodass der erste Kundenkreis recht klein bleibt. Die sogenannten „Early Adopters“ kaufen die Funktionalität (fast) ohne Rücksicht auf den Preis. Die Basis-Funktionalität (und nur diese) sind Hauptargument für den Kauf. Die Fahrzeuge haben noch viele Schwächen und bieten wenig Komfort.

Für neue Produkte in der Phase eins empfiehlt Guy Kawasaki, das Produkt möglichst rasch auf den Markt zu bringen, um das reale Kundenfeedback (in Form der tatsächlichen Nutzung) zu erhalten und dabei auch ein gewisses Maß an Unzulänglichkeit („Crappiness“) in Kauf zu nehmen – in der ersten Phase muss das Produkt nicht perfekt sein, sondern nur die Anforderung an die Funktionalität erfüllen.

Die Hersteller bemerken das Interesse der Kunden und verbessern ihre Produkte so, dass diese besser zu den Kundenbedürfnissen passen. Die kontinuierliche Verbesserung wirkt sich auf den Preis aus und vergrößert gleichzeitig die Käuferschar. An einem Punkt X genügt es für Anbieter auf dem Auto-Markt plötzlich nicht mehr, einfach nur ein weiteres Modell anzubieten. Die Basis-Funktionalität ist etabliert und akzeptiert und stellt keinen eigenen Kaufanreiz mehr da. Mit einem motorbetriebenen Gefährt statt mit Pferden zu fahren und Waren zu transportieren wird als selbstverständlich für diese Produkte vorausgesetzt.

Zu solchen Basis-Anforderungen gehört beispielsweise, dass die Gefährte eine Reisegeschwindigkeit von 100 oder 120 km/h bieten, einen verträglichen Verbrauch aufweisen, in einer akzeptablen Zeit von 0 auf 100 beschleunigen. Eine Maximalgeschwindigkeit von über 200 km/h ist für die Kundenmasse uninteressant. Die Produktentwicklung hat in Bezug auf Funktionalitätsangebote die Kundenbedürfnisse überholt. Wenn alle Produkte der Kategorie „Auto“ die Basis-Anforderungen an Funktionalität erfüllen, sind neue Kriterien nötig, um die Produkte voneinander zu unterscheiden und sowohl einen Vorsprung gegenüber den Konkurrenzanbietern herzustellen als auch einen Anlass für höhere Preise zu rechtfertigen.

2. Zuverlässigkeit

Werden also die Grundfunktionalitäten geboten, dann ist das nächste Kriterium für eine Kaufentscheidung bzw. für „Premium pricing“ die Zuverlässigkeit. Die bestehende Technologie wird optimiert, verbessert und wartungsfreundlicher gestaltet. Diese „sustaining“ Entwicklungen sorgen für ein gleichbleibendes Preisniveau (möglichst hoch). Natürlich könnte jeder Hersteller weiter Produkte der ersten Generation produzieren und diese günstiger anbieten, doch die Kunden geben sich nicht mehr nur mit der Funktionalität zufrieden. Für sie wird zunehmend die Zuverlässigkeit dieser Funktionalität selbstverständlich bzw. sie verweigern den Kauf, wenn die Funktionalität nicht mit einer höheren Zuverlässigkeit angeboten wird.

Doch auch die Möglichkeiten zur Zuverlässigkeitssteigerung sind irgendwann ausgereizt. Ab einem Punkt X ist die Zuverlässigkeit aus Kundensicht gut genug. Für die Kundenmasse ist es akzeptabel, dass ein Fahrzeug alle 15.000 oder 20.000 Kilometer zur Durchsicht muss. Eine Verbesserung der Zuverlässigkeit auf Intervalle von 30.000 oder gar 40.000 Kilometer ist für die wenigsten ein relevantes Kriterium, um einen Aufpreis gegenüber den anderen Produkten zu bezahlen. Also benötigt es die dritte Phase, um erneut Anreize zu schaffen, damit die Kunden weiter hohe Preise zahlen.

3. Bequemlichkeit/Komfort

Die Funktionalität ist so selbstverständlich, dass niemand mehr darüber spricht: Ein Auto fährt motorgetrieben von A nach B, eine Tankladung reicht mindestens 500 Kilometer, alle 20.000 Kilometer wird eine Wartung fällig. Aber die Sitze könnten etwas bequemer sein. Warum muss man eigentlich die Fenster kurbeln? Was geschieht eigentlich im Fall eines Unfalls? Muss ich eigentlich selbst fahren? Wieso muss sich das Auto im Sommer so aufheizen? Warum ist es im Winter so kalt?

Zahlreiche Komfortangebote (Ausstattungsvarianten, elektrische Fensterheber, Airbags und andere Sicherheitssysteme, Fahrassistenten, Klimaanlage, Standheizung und beheizbare Sitze) sorgen für die nötige Differenzierung auf dem Markt und halten das Preisniveau hoch. Sicher, es gibt auch Anbieter, die bewusst in der zweiten Phase bleiben und sehr günstige Fahrzeuge mit wenig Komfort-Funktionen anbieten. So wird der Markt bzw. so werden die Kunden segmentiert – nicht mehr über Funktionalität und nicht mehr die Zuverlässigkeit, sondern die Ausstattung, die Bequemlichkeit (der Luxusgrad) entscheidet über den Preis (den man fordern bzw. zahlen will).

4. Preis

Sind alle anderen Parameter gleich (bzw. erfüllen alle Angebote die Mindest-Anforderungen an Funktionalität, Zuverlässigkeit und Komfort), findet die Differenzierung der Produkte über den Preis statt.

Natürlich ist diese Betrachtung insgesamt arg verkürzt und verallgemeinernd, für zahlreiche Bereiche ließen sich eigene Phaseneinteilungen vornehmen:

- Unterhaltungsangebote im Auto: vom Mono-Radio über CD-Wechsler bis zum Entertainment-System

- Sicherheit: von Knautschzonen und Stoßstange über Airbag und EPS bis zum mitdenkenden Auto, das selbstständig in kritischen Situationen eingreift

- Bequemlichkeit: von Sitzen über Fensterheber bis hin zu automatischen Dacheinklappungen für Cabrios.

Und auch für jeden Unterbereich ließen sich wiederum die vier Phasen verfolgen.

Lehre/Lektion

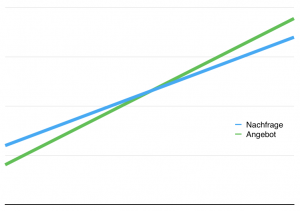

Es gibt einen steten Wettlauf zwischen Kundeninteresse und -kaufbereitschaft und Produktentwicklung, und beide beeinflussen sich gegenseitig. Das Interesse kann als Nachfrage, Demand, Bedürfnis, Anforderung o.ä. konkretisiert werden. Es ist die jeweilige Qualitätsstufe, die von den Kunden gefordert wird, um einen Kauf ernsthaft in Erwägung zu ziehen oder gar zu tätigen. Das entsprechende Angebot ist entweder in dem geforderten Ausmaß vorhanden – oder (noch) nicht. Eine Raumfahrt ist sicherlich für viele Kunden interessant, doch entspricht das aktuelle Angebot nicht ihren Bedürfnisse: Es ist zu teuer, zu aufwändig, zu begrenzt. Daher würden allenfalls die „Early Adopter“ die aktuellen Angebote nutzen und die damit verbundenen Einschränkungen in Kauf nehmen. Der Markt unterbreitet also ein Angebot, für dessen aktuelle Ausprägung das Kundeninteresse (aus verschiedenen Gründen) noch nicht in ausreichendem Maße besteht. Wird das Kundeninteresse durch das Marktangebot jedoch abgedeckt, dann folgt die nächste Phase zur Ausdifferenzierung der Angebote bzw. Erweiterung des Basis-Angebots, um das Preisniveau zu halten.

In jeder der vier Phasen könnte man ein Diagramm zeichnen, in dem die Angebote auf der vertikalen Achse graduell eingetragen werden und auf der zweiten Achse die Zeit:

Was im ersten Moment lediglich als Sättigung eines Marktes interpretiert werden kann (quantitativ), gilt auch für die Sättigung des Kundenbedürfnisses nach einer bestimmten Eigenschaft (qualitativ). Beispiele dafür sind Festplattenkapazität, Wartungsintervalle bei Fahrzeugen, gefühlter Stress bei der Erledigung bestimmter Aufgaben, Komplexität von Tätigkeiten, Reinheit von Insulin. Ab einem bestimmten Punkt ist das Kundeninteresse befriedigt, und die weitere Optimierung bringt keinen zusätzlichen Kaufanreiz. Die weitere Verbesserung ist allenfalls für einen speziellen Nischenmarkt relevant.

Mit „Angebot“ ist auch die technologische Entwicklung gemeint. Diese bleibt zunächst unter den Kundenbedürfnissen, denn Kunden wollen immer mehr, schneller, billiger. Doch ab einem bestimmten Moment sind die Kundenbedürfnisse erfüllt, die weitere Entwicklung über diese Bedürfnisse hinaus ist wirtschaftlich unattraktiv. Oberhalb der Kreuzung beider Linien erfolgt der Wechsel in die nächste Phase. Ein „Curve-Jump“ ist nötig, eine „disruptive“ Entwicklung hat die Möglichkeit, neue Produkte am Markt unterzubringen. Drei Ergebnisse oberhalb der Linienkreuzung sind möglich:

- Eine neue Funktionalität macht Gebrauch von der entstehenden Mehrleistung (damit beginnt eine neue Kurve für eine neue Produktkategorie).

- Die Leistung wird in anderer Form angeboten (damit beginnt eine neue Kurve unterhalb der Kreuzung für die gleiche Produktkategorie; ein Beispiel sind die Festplattengrößen, kleinere Festplatten haben weniger Kapazität, bleiben somit innerhalb der Festplattenkategorie unter den Erwartungen, sie ermöglichen jedoch neue Einsatzzwecke, für die dann eine neue Produktkategorie geschaffen wird).

- Der Markt bleibt im Wesentlichen bestehen wie er ist, die Unternehmen widmen sich anderen Produkten, und irgendwann wird die Nachfrage so weit sinken, dass keine Angebote mehr nötig sind.

Nebenbeobachtung

In Bezug auf das Gesundheitssystem befinden wir uns in Phase vier. Die anderen drei Phasen sind bereits durchlaufen:

- Die Todesrate für die meisten Erkrankungen und Verletzungen ist signifikant gesunken. Mit teilweise geringem Aufwand (Penicillin) können enorme Senkungen der Todesrate einhergehen.

- In vielen Regionen gibt es ein genügend engmaschiges Netz zur Gesundheits- und Notfallversorgung. Das System als solches funktioniert relativ robust und zuverlässig.

- Der Arzt- oder Krankenhausbesuch ist gut in den Alltag integrierbar, und die Patienten werden als „Kunden“ behandelt, also nicht als Bittsteller, sondern als Menschen mit berechtigten Anforderungen. Die Ausstattung ist zumeist hinreichend modern, und oft wird eine gute Bequemlichkeit bzw. geringe Unangenehmheit geboten.

Die Kundschaft erwartet (unbewusst) nun eine Ausdifferenzierung des Marktes über den Preis. Diese unterbleibt jedoch aufgrund der Organisation des Gesundheitswesens. Da die Grundbedürfnisse (Funktionalität und Zuverlässigkeit) in vielen Ländern verlässlich erfüllt werden, liefert der sogenannte Gesundheitstourismus in einigen Segmenten diese Preisdifferenzierung. Natürlich kann man auch argumentieren, dass jeder Preis angemessen sei, der für eine Leistung fällig ist, die dafür sorgt, dass man nicht stirbt. Auch wenn es rational und plausibel klingt – es fühlt sich nicht korrekt an.

Salopper formuliert: Je selbstverständlicher (und weniger riskant) etwas ist, desto weniger sind Kunden bereit, dafür zu bezahlen. Da es nicht im Interesse der Anbieter liegt, dass die Preise stetig fallen (was ja die Rentabilität beeinträchtigt), sorgen sie mittels Verbesserungen in den Bereichen Zuverlässigkeit und Convenience für Argumente, um die Preise auf Premium-Niveau zu halten. Das ist in einigen Märkten einfacher (Technik, Elektronik) und in anderen schwieriger (Gesundheitswesen).

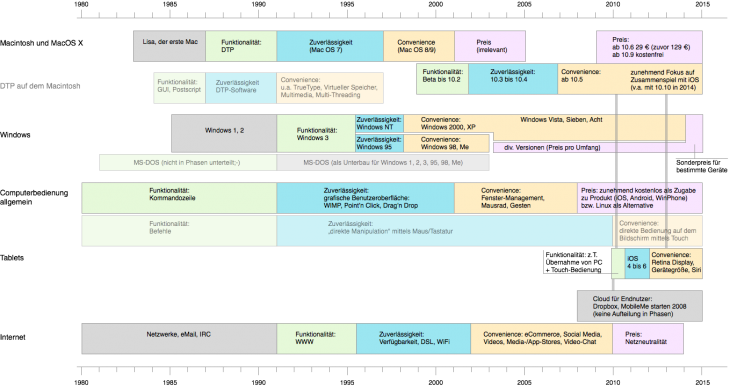

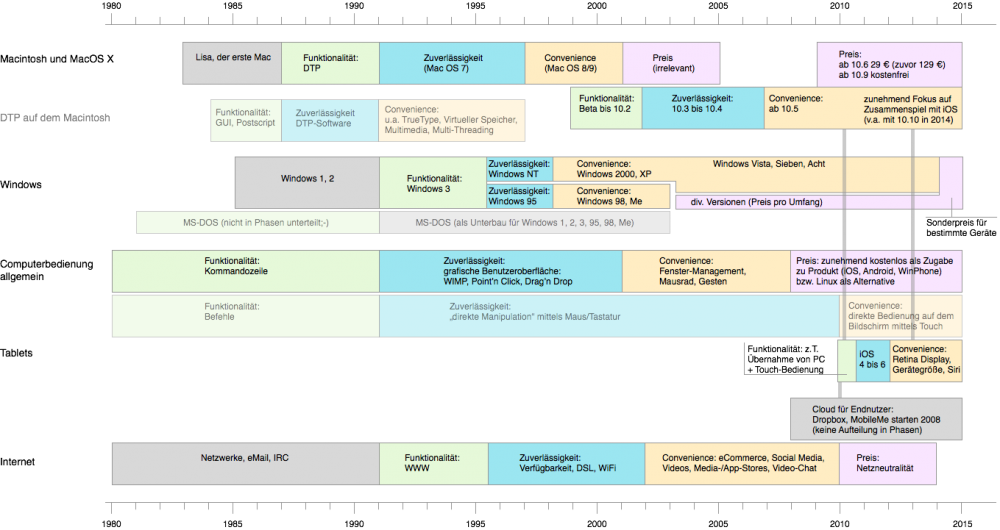

Überblick über die Phasen der Computergeschichte

Die vier Phasen (Differenzierung nach Funktionalität, Zuverlässigkeit, Convenience und Preis) jeweils für einzelne Bereiche der Computergeschichte.

Natürlich basiert eine solche diagrammatische Darstellung auf drastischer Komplexitätsreduzierung und interpretiert eine phasenweise Entwicklung in Etappen. Über jede Box ließe sich ein eigenes Kapitel verfassen, worauf ich aber verzichte. Die Übersicht verdeutlicht vor allem, dass die Phasen sich zum Teil überlagern und mehrere durchaus parallel verlaufen können. Je nach Fokus oder Betrachtungsperspektive sind verschiedene Einteilungen möglich – mit jeweils unterschiedlichen Ergebnissen und Konsequenzen.

Der Mac ohne Funktionalität

Als 1984 der Macintosh präsentiert wurde, waren Computer für die meisten Nutzer noch kräftige Maschinen. Der Mac vermittelte aber allein durch seine Erscheinung nicht den Eindruck, eine leistungsfähige Maschine zu sein. Die Kunden – jedenfalls der große Teil – benötigte wenn überhaupt, allenfalls die Funktionalität eines DOS-PCs und keiner grafischen Oberfläche. Oder andersherum: Der Mac bot eine andere Funktionalität, als die Kunden von einem Computer erwarteten, und nur für wenige war die Funktionalität des Mac relevant genug, das Produkt zu kaufen.

In der ersten Phase – die Zeit des Entstehens einer PC-Arbeitswelt – zählte allein die Funktionalität als Kaufkriterium, nicht die Zuverlässigkeit, nicht der Komfort, und für die Early Adopter auch nicht der Preis. In Bezug auf den Computer-Gesamtmarkt gab es also wenig Interesse am Mac. Er fand aber eine Nische in diesem Gesamtmarkt, die die Funktionalität (grafische Oberfläche) des Mac zu schätzen wusste und für diese den Preis zu zahlen bereit war.

Neue Funktionalität = ein echter Markt

In den Folgejahren baute der Mac seine Funktionalität und Zuverlässigkeit weiter aus. Und dann erschien 1987 mit dem Programm „Aldus PageMaker“ ein Programm, das dem Mac eine neue Funktionalität gab: Desktop Publishing. Ohne diese wäre er funktionsmäßig immer mit den übrigen PCs und deren DOS-Oberfläche verglichen worden. Da aus Kundensicht alle die gleichen Funktionen (z.B. Textverarbeitung, Berechnungen anstellen) boten, war der Komfort-Mehrwert des Mac noch kein Marktkriterium.

Mit Blick auf die allgemeine Computerentwicklung war der Mac seiner Zeit also zu sehr voraus, indem er den Komfort zur Funktionalität erhob, bevor der Großteil des potenziellen Markts überhaupt die Funktionalitäten von Computern als selbstverständlich akzeptiert hatten.

Daher waren auch den zahlreichen grafischen Benutzeroberflächen anderer Hersteller wenig Erfolg in den 1980ern beschieden. Nur wenige Kunden waren bereits „so weit“, dass sie in die nächste Phase mitgingen.

Als dann die vier Phasen der Kommandozeilen-Ära (DOS) durchlaufen waren und mit Linux Anfang der 1990er ein kostenloser Anbieter die Bühne betrat, war die Computerwelt bereits auf dem Weg einer „disruptive“ Entwicklung: die grafische Benutzeroberfläche erfüllte mit Windows NT (und 95/98) die Anforderungen an Funktionalität und oft genug an Zuverlässigkeit; für Privatanwender sind die Zuverlässigkeitsanforderungen noch nicht so hoch, daher genügte Windows 95/98 deren Ansprüchen. Mit Windows XP (2001) war die grafische Oberfläche selbstverständlich und in Phase drei angekommen.

Neuer Durchlauf durch die Phasen

In der Zwischenzeit hatte Apple sein Betriebssystem auf Unix-Füße gestellt und unter dem Namen MacOS X einen neuen Durchlauf durch die Phasen für sich begonnen. Die erste Version erfüllte Phase eins, ab Version Mac OS 10.4 war die Phase zwei abgeschlossen, und Mac OS befand sich mitten in Phase drei.

Natürlich ist es arg verkürzend, Mac und Windows zu vergleichen, denn Macs bestehen aus Hard- und Software, während Windows auf nahezu allen PCs läuft. Aber in Bezug auf die Phasen lässt sich konstatieren, dass die Funktionalität einer grafischen Benutzeroberfläche für nahezu alle Kunden selbstverständlich geworden war und als Standard vorausgesetzt wurde. Die bessere Zuverlässigkeit lockte viele Kunden, die bislang auch ohne grafische Oberfläche auskamen („das bestehende System läuft doch stabil, und ich kann alles machen“) zu einem Wechsel auf das neue System.

Auf einem rausgezoomten Level ist die grafische Oberfläche die Phase drei der Computergeschichte, nämlich mehr Bequemlichkeit/Komfort (wobei wir noch nicht wissen, ob in mehreren Jahren auch diese Ansicht überholt sein wird). Der Computermarkt war also insgesamt in Phase drei. Der Mac übernahm mit seinem besseren Komfort die Führung als Referenzplattform und konnte seine Marktanteile kontinuierlich ausbauen.

Die Aufteilung nach dem Phasenmodell unterlegt der Mac-Geschichte eine inhärente Narration und somit Kausalität. Diese geht verloren, wenn man sich auf Einzelaspekte oder geschichtliche Momente verloren.

Teilmarkt: DTP

Auf dem Teilmarkt des Desktop Publishing, der ab Mitte der 1980er vermehrt auf Macs gesetzt hatte, waren die Funktionalität und Zuverlässigkeit des Mac sowie dessen Komfort ausreichend. Als auch Windows-Computer ab Anfang der 1990er grafische Oberflächen boten und Desktop Publishing ermöglichten, trat der DTP-Teilmarkt in die vierte Phase, in der über den Preis entschieden wird. Dadurch verlor Apple viele Marktanteile und konnte diese erst in anderen Teilmärkten wieder hinzugewinnen, in denen die Kunden sich in anderen Phasen befanden – weil sie andere Anforderungen hatten.

Diese Betrachtung der Computergeschichte nach dem Phasenmodell macht – zumindest für mich – einige Phänomene erklärbar und plausibel. Denn sie berücksichtigt das Umfeld aus Marktsituation, Kundenerwartungen und den Kontext der Zeit. Dabei lassen sich die Phasen sowohl auf einem Mikro-Level in Bezug auf einzelne Produkte (Software/Hardware) als auch auf der Makro-Ebene anwenden. Dabei ist natürlich zu berücksichtigen, dass alle Aussagen über Kundeninteresse nur den jeweiligen Gesamtmarkt betreffen und nicht die Individuen – aber eine solche Aggregation hilft auch beim Verständnis. Denn für die meisten Produkte ist statistisch eher der Gesamtmarkt relevant als der individuelle Kunde mit seiner Meinung. Das gilt insbesondere, wenn der Markt nicht mehr in Tausender-Verkaufszahlen angegeben wird, sondern in Millionen-Stückzahlen.

Lektionen zu iPad und anderen Tablets

Beim Newton (1993 bis 1998) – das ist die Kurzfassung – wurde statt eines funktionierenden Personal Digital Assistant (PDA) das perfekte Gerät angestrebt. Das ließ die Kosten und Nutzererwartungen steigen. Mit 140.000 verkauften Geräten wäre es für ein kleines Unternehmen kein Flop und übertraf auch die Verkaufszahlen der frühen Apple-Computer deutlich. Für die gewachsene Firma Apple waren die Stückzahlen jedoch zu gering. Statt ein funktionierendes Gerät auf den Markt zu bringen, dessen Nutzer zu beobachten und anschließend das Gerät auf die tatsächliche Nutzung hin zu optimieren, wurden Features über Features integriert. Das fertige Produkt überzeugte zwar mit vielen raffinierten Ideen, enttäuschte aber als Gesamtgerät, weil einige der Basis-Funktionen nicht wie erwartet funktionierten (prominent die Handschrifterkennung). Für ein Unternehmen wie Apple in den 1990ern war der Newton insgesamt ein zu teures Projekt geworden, um es weiter zu betreiben. Den PDA-Markt übernahmen dann Start-Ups wie Palm (gegründet 1992).

Beim iPhone und iPad agierte Apple cleverer: Das Produkt war beim Marktstart fokussiert und beherrschte die Basis-Funktionen gut. Verbesserungen und Erweiterungen erschienen mit jeder neuen Software-Version bzw. Geräte-Generation: z.B. Copy & Paste, Apps und AppStore, Multitasking, Kamera im iPad. Die Software für iPhone und iPad basierte auf dem Betriebssystemkern von MacOS X. Features und Funktionen konnten aus der Computerwelt direkt für die Mobilgeräte übernommen und an die andere Bedienung angepasst werden. Somit starteten beide Geräte jeweils mit gereifter und erprobter Software. Das verkürzte die Funktionalitätsphase so wie es beim Newton erhofft war, aber aufgrund der Gesamtneuheit nicht erreicht werden konnte.

Für die Betrachtung der Tablets ist entscheidend, ob man sie im Gesamtmarkt aller Computer betrachtet oder als Einzelmarkt. Im ersten Fall gehören sie zu Phase 3, bieten also mehr Bequemlichkeit und Komfort. Das bedeutet, die Phase vier – Differenzierung über den Preis – baut sich gerade auf.

Als Einzelmarkt betrachtet, ist es schwerer, die Phasen zu bestimmen. Der Tablet-Markt (jedenfalls als Angebot für die Masse) wurde 2010 mit der Einführung des iPad begründet. In den vier Jahren seitdem wurde die Funktionalität etabliert, und heute erwarten alle Nutzer eines Tablets:

- Surfen

- Spielen

- eMail-Programm

- soziale Netzwerke und Kontakte

- Medien konsumieren: Bücher, Bilder, Texte, Musik, Filme

- Apps für kreative Zwecke

- mehr Nutzfläche als auf einem Smartphone

Die benötigte Zuverlässigkeit – in Form von Akkuzeit und Absturzseltenheit und Problemarmut – wurde de facto ebenfalls erreicht. Die aktuellen Angebote versuchen, sich über Komfort und Preis zu differenzieren. Die Preisdifferenz wird mit Abstrichen bei der Hardware-Ausstattung erkauft, dadurch kann mitunter eine Funktionalität nicht wie erwartet umgesetzt werden.

Aufgrund der Fortschritte in der Computerbedienung (Selbstverständlichkeit der grafischen Benutzeroberfläche) werden auch an Tablets die gleichen Anforderungen gestellt. Jedes Gerät, das für die gleiche Funktion (z.B. Surfen, Medienkonsum) eine schlechtere Funktionalität oder Zuverlässigkeit bietet, hat einen schweren Stand auf dem Markt. Natürlich sind einige Funktionen gerätebedingt beschränkt, aber jede nicht einsichtige Beschränkung wird als Mangel wahrgenommen. Dass auf einem Tablet einige Webseiten etwas verfälscht dargestellt werden, ist hinnehmbar. Nicht akzeptabel ist für Kunden jedoch, wenn das Scrollen ruckelt. Sauberes Scrollen ist für Kunden kein Convenience-Feature, sondern eine Basis-Anforderung, eine Selbstverständlichkeit. Wird diese nicht erfüllt, entsteht das Gefühl der Nichtkorrektheit des Gesamtgerätes und somit eines Gerätemangels.

Disruptive trotz Größe

In Bezug auf die Tablets hat Apple etwas sehr Unorthodoxes getan. Während laut Christensens Beobachtungen es selten gelingt, eine „disruptive“ Entwicklung innerhalb eines großen Unternehmens umzusetzen, scheint dies Apple gelungen zu sein. Christensen führt mehrere Gründe für das von ihm beobachtete häufige Scheitern an, u.a.:

- Für große Unternehmen ist der entstehende neue Markt wirtschaftlich meist zu unbedeutend, daher wird er erst angegangen, wenn er größer geworden ist.

- Große Unternehmen haben etablierte Prozesse und Kulturen und Entscheidungswege (z.B. bei der Ressourcenverteilung), die sich mit der Start-up-Mentalität von „disruptiven“ Produkten schlecht vertragen.

- Große Unternehmen erwarten von ihren Produkten eine bestimmte Marge, um sich diesen zu widmen. Die Entwicklung erfolgt stets von unten nach oben: Firmen starten mit geringen Margen (um den Markteintritt zu schaffen) und arbeiten sich dann über Jahrzehnte zu den Premium-Margen nach oben.

Vor diesen Problemen stehen auch alle iPad-Konkurrenten. Apple selbst verdient mit dem iPad deutlich niedrigere Margen als mit seinen anderen Produkte, was atypisch ist und besondere Herausforderungen an die Unternehmenskultur stellt. Andere Unternehmen, die ein vergleichbares Produkt anbieten wollen, müssen die niedrigeren Margen akzeptieren, um auf dem Markt bestehen zu können. Wenn ihre Unternehmenskultur es nicht akzeptiert, deutlich unter ihren sonstigen Margenerwartungen zu agieren, sind sie zum Scheitern verurteilt.

Das erfolgreichste Nicht-iPad-Tablet stammt von Amazon, die kaum durch andere Hardware-Produkte andere Margenerwartungen pflegen konnten. Somit scheitern manche Tablet-Projekte bereits in ihren eigenen Unternehmen bzw. können durch das Unternehmen nicht die nötige Unterstützung erfahren bzw. stehen unter ständigem Rechtfertigungsdruck: „Warum sollen wir Ressourcen in diesen Bereich stecken, der uns weniger einbringt als die anderen Unternehmensbereiche? Wir sollten dieses (nette) Experiment lieber beenden und wieder richtig Geld verdienen.“

Phase vier der Tablets?

Es ließe sich gut argumentieren, dass bei den Tablets bereits die dritte Phase durchlaufen wurde und nun die Differenzierung über den Preis stattfindet. Diesen Wettbewerb scheint – jedenfalls nach abgesetzten Stückzahlen – Apple für sich entschieden zu haben. Durch bessere Convenience (die letztlich mehr ist als Bequemlichkeit/Komfort) könnte es anderen Anbietern gelingen, sich einen Vorsprung zu erarbeiten. Den deutlichsten Vorstoß in dieser Richtung hat Apple erfolgreich mit der Einführung des iPad mini gekontert und das Komfort-Kriterium der Gerätegröße adressiert. Daneben können beispielsweise auch Retina Display und Siri als Convenience-Kriterien gelten, die den Wert des Gerätes steigern. Ein Tablet in der iPad-Preisregion wird kaum Käufer finden, wenn es nicht die gleichen Features und Funktionen wie ein iPad anbieten kann, denn die iPads haben die Gerätekategorie quasi definiert und geben bislang den Standard und damit das von den Kunden als selbstverständlich Erwartete vor.

Wenn wir uns tatsächlich bereits in Phase vier befinden, hat dies zwei Konsequenzen:

- Irgendwo wird das nächste „disruptive“ Produkt entwickelt, das die Tablet-Kategorie auf die nächste Kurve hebt.

- Die Preisdifferenzierung segmentiert den Markt in mindestens drei Bereiche: billig, moderat, Premium.

Der moderate und Premium-Bereich werden vor allem von Apple derzeit gut abgedeckt, wobei die Zusatzoptionen an Speicher und Internetverfügbarkeit (3G/4G oder nur WiFi) das eigentliche Premium ausmachen. Im billigen Bereich tummeln sich Geräte anderer Hersteller, die ihren Kunden Abstriche an Funktionalität, Zuverlässigkeit und/oder Convenience abverlangen. Dafür verzichten die Hersteller zugunsten (imaginärer/erhoffter) hoher Stückzahlen auf hohe Margen.

Phase eins der Tablets?

Beurteilt man Tablets nach Computermaßstäben, scheinen wir uns tatsächlich in Phase vier zu befinden. Doch aus einer anderen Perspektive lässt sich die Argumentation eröffnen, dass sich die Tablets gerade erst am Anfang befinden. Die Funktionalitäten wurden vom Computer in diese neue Gerätekategorie überführt. Doch diese Gerätekategorie ist durch mehr definiert als im ersten Moment ersichtlich ist:

- Bestimmte Funktionalitäten des Computers (z.B. Surfen, Medienkonsum, eMail, Spiele) stehen zur Verfügung.

- Diese Funktionalitäten sind an die andere Bedienweise (direkte Bildschirmbedienung statt indirekte Bedienung via Maus/Tastatur) angepasst.

- Die Geräte besitzen eine kompakte Gerätegröße, die die „casual“ Benutzung unterstützt. Die Geräte werden häufig für kurze Aktionen genutzt und nicht in der Intensität wie ein Computer.

- Die Arbeitsdaten stehen nicht in einem Dateimanager zur Verfügung, nicht-lokale Datenhaltung, damit geräteunabhängige Datenhaltung (Cloud) sind integriert.

Gerade der letzte Punkt ist entscheidend für die Argumentation. Auf einem Computer liegen die Daten lokal vor, da Speicherplatz billig und quasi unendlich ist. Viele Menschen nutzen nur einen Computer, sodass die zentralisierte Datenhaltung keinen Komfortverlust bedeutet. Tablets jedoch verfügen über deutlich weniger Speicher, und das Gerät wird häufig als Zweit- oder Drittgerät neben anderen verwendet. Damit ist die Datenhaltung die entscheidende Herausforderung, die für die Gerätekategorie Tablet besteht. Schließlich wollen die erstellten Daten auch bequem und unaufwändig von einem Gerät an andere zur weiteren Nutzung übertragen werden.

Schließt man also die Cloud in die Betrachtung mit ein, dann ist die Behauptung legitim, dass wir uns in Phase eins befinden, vermutlich im Übergang zu Phase zwei:

- Die Cloud-Funktionalität besteht auf allen Geräten, ob mit iOS, Windows oder Android.

- Für viele Anwender ist die Nutzung jedoch noch nicht selbstverständlich, und regelmäßig wird von Problemen berichtet. Die Cloud-Lösungen bieten insgesamt noch nicht die Zuverlässigkeit und Reibungslosigkeit, die für den bedenkenlosen Alltagseinsatz benötigt wird. Im besten Fall haben sie – nach meiner Schätzung – 90 Prozent der Ziel-Zuverlässigkeit erreicht. Trotz zahlreicher schöner Funktionen (wie automatische Foto-, Datei-, und Medien-Synchronisation) hakelt es im Alltag zu oft, um von selbstverständlicher Zuverlässigkeit zu sprechen.

- Bereits jetzt werden Komfort-Funktionen angeboten. Die Phasentrennung erfolgt in der Praxis ja nie so präzise, wie man es in der Theorie gern hätte. Die Unternehmen versuchen mittels Convenience die Attraktivität ihrer jeweiligen Angebote zu steigern: einfache Synchronisation, automatischer Abgleich bestimmter Systeminformationen (z.B. Passwörter), Zugriff auf Medienangebote etc. Auch hier ist noch viel Platz nach oben.

- Die Preisdifferenzierung findet bislang indirekt statt. Jeder Anbieter bietet eine kostenlose Version mit den Basis-Funktionen. Diese dient vorwiegend dazu, die Kunden von der Nutzung zu überzeugen und wird über den Verkaufspreis subventioniert. Die Cloud-Angebote sind quasi die automatische Ergänzung zum Tablet-Kauf. Die kostenpflichtigen Varianten bieten meist nur ein Mehr zur kostenlosen Basis-Version: v.a. mehr Speicherplatz.

Das vorgestellte Phasen-Modell ist ein weiterer Erklärungsansatz, um bestimmte Entwicklungen besser zu verstehen. Gerade die Beziehung zwischen Kundeninteresse und Angeboten bietet einen Mehrwert gegenüber vielen Erklärungen. Die vierfache Erreichung der optimalen Balance zwischen Angebot und Nachfrage berücksichtigt die tatsächlichen Gegebenheiten und holt die Masse der Endverbraucher in einer Weise in den Fokus, dass plausiblere Aussagen entstehen als von allen Experten. Christensen selbst erklärt: „Experts’ forecasts will always be wrong“ (die Voraussagen von Experten stimmen nie).

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||