Die allerersten Computer wurden mit Schaltern bedient. Später erhielt der Computer Eingaben über gestanzte Lochkarten, ähnlich denen, mit denen im Jahrhundert zuvor mechanische Webstühle programmiert wurden. Der „Nutzer“, eher der Programmierer, fertigte ein Lochband oder eine Lochkarte mit seinen Eingaben (Programmcode und Daten) an. Statt über eine Tastatur direkte Anweisungen geben zu können, wurden diese in Papier vor-codiert.

Der Beitrag bildet das dritte Kapitel im Buch „Der Apple-Faktor“. (bei amazon.defür 14,90 Euro bestellen)

In den 1960er Jahren fehlte den Computern noch die Leistungsfähigkeit, mehr zu tun als entweder Eingaben entgegenzunehmen oder Daten auf dem Bildschirm auszugeben oder Berechnungen auszuführen. Der Computer wartete entweder auf Eingaben oder führte sie aus. Beides gleichzeitig ging nicht. Mit einem blinkenden Cursor signalisierte der Computer, dass er auf eine Eingabe wartet – außer Warten tat er in der Zeit nichts. Der Nutzer gab seine Befehle ein, und wenn er [Enter] drückte, wurden die Befehle ausgeführt; der Eingabecursor verschwand, und der Nutzer wartete. Nach dem Ende der Befehlsausführung wurde eine kurze Statuszeile ausgegeben, hinter der der Cursor wieder eingabefreudig blinkte.

Die ↑ Kommandozeile war keine Errungenschaft, sondern die einzige Möglichkeit, sauber zwischen Datenein- und -ausgabe zu unterscheiden. Als mit den Jahren die Leistungsfähigkeit der Computer wuchs, stiegen auch die Ansprüche und Erwartungen an die Computer. Sie sollten mehr können als nur entweder warten oder ausführen. Die wichtigsten Tätigkeiten von Computern sind:

- Daten entgegennehmen: von Tastatur abfragen oder aus anderen Quellen auslesen

- Daten berechnen, verarbeiten

- Daten ausgeben: auf dem Bildschirm, auf einem Drucker, auf einen Datenträger schreiben

Manche davon lassen sich gut gleichzeitig ausführen, andere nicht. Aber warum soll ein Computer keine Tastatureingaben entgegennehmen können, während er im Hintergrund eine Druckerausgabe berechnet und die Daten an den Drucker schickt? Vorausgesetzt, er ist schnell genug, auch tatsächlich beides zu können. Doch Computer können prinzipbedingt nicht mehrere Dinge auf einmal tun, da sie nur ein Steuergerät (Controller) haben, das die Aufgaben verwaltet und verteilt. Jedoch kann – das hat die Rückführung jeder Aktion in eine Addition bewiesen – jede Aufgabe in kleine Aufgaben zerlegt werden. Wenn der Computer schnell zwischen den Teilaufgaben hin- und herschaltet, entsteht die Illusion, er würde mehrere Aufgaben gleichzeitig bewältigen.

Scheinbare Gleichzeitigkeit

Diese Umschaltung ist so schnell, dass sie nur auffällt, wenn sie nicht funktioniert. Im Normalfall könnte die Schaltung so ablaufen: Tastatur auslesen, Bildschirmsignal berechnen, geforderte Berechnung im Hintergrund ausführen, Netzwerkaktivität, Daten in Arbeitsspeicher schreiben, Tastatur auslesen, geforderte Berechnung im Hintergrund ausführen, Daten aus Arbeitsspeicher auslesen, Bildschirmsignal berechnen. Damit keine Tastatureingaben verlorengehen, fragt der Computer nicht selbst die Tastatur ab, sondern liest den Tastaturpuffer aus. In diesem wird jede gedrückte Taste registriert. Je nach Computertyp kann sie einige wenige oder mehrere Dutzend Tastenanschläge speichern, die der Computer dann als Tastatureingabe entgegennimmt.

Die Zerlegung von großen Aufgaben in kleine lohnt sich besonders, wenn ein Computer mehrere Prozessorkerne besitzt. Dann kann er Teilaufgaben auf diese verteilen und somit quasi parallel bearbeiten. Doch manche Prozesse hängen voneinander ab und benötigen die Ergebnisse oder Eingaben von anderen Prozessen. Klicke ich im Taschenrechner-Programm eine komplizierte Berechnung zusammen, kann ich die Maus bewegen, obwohl die Berechnung noch nicht beendet ist. Denn die Abfrage der Mausbewegung und Darstellung des Mauszeigers auf dem Bildschirm sind eigene Prozesse, die nicht vom Berechnungsprozess abhängig sind. Doch kann der Taschenrechner meist keine Eingaben annehmen, bis das Ergebnis vorliegt bzw. neue Eingaben brechen die Berechnung ab oder werden erst ausgeführt, sobald die Berechnung beendet ist und überschreiben damit sofort das Ergebnis – je nachdem, wie der Taschenrechner programmiert wurde.

Kann von einem Prozess nicht schnell genug weitergeschaltet werden oder kommt der Controller bei der Verteilung durcheinander, scheint der Computer zu „hängen“. Eingaben erscheinen nicht auf dem Bildschirm, der Nutzer fühlt sich hilflos. Plötzlich läuft das Gerät weiter und trägt die in der Zwischenzeit aufgelaufenen Eingaben auf dem Bildschirm nach. Der Tastaturpuffer hatte die letzten Eingaben gespeichert und liefert sie aus, sobald der Computer aufnahmebereit ist. Im Normalfall ist die Verzögerung zwischen Eingabe – Tastaturpuffer – Reaktion auf Bildschirm aufgrund der schnellen Umschaltzeiten so kurz, dass man sie gar nicht wahrnimmt. Auch die Maus verfügt über einen Pufferspeicher, der Bewegungen und Klicks speichert, bis der Computer zur Maus schaltet, um die angelaufenen Bewegungen abzuarbeiten.

In den 1980ern konnten PCs schnell genug zwischen einzelnen Aufgaben umschalten. Damit war es möglich, Computer nicht mehr nur seriell zu bedienen. Der Computer konnte scheinbar zwei Dinge gleichzeitig: Eingaben entgegennehmen und ein Programm abarbeiten. Tabellenkalkulationen beispielsweise leben von diesem Umschalten. Denn eine Tabelle seriell zu befüllen, wäre mühselig. Stattdessen wird die Tabelle dargestellt, der Textcursor kann frei bewegt werden und an geeigneter Stelle Werte eintragen oder Menübefehle aufrufen. Mit einem bestimmten Befehl werden dann die Berechnungen der Tabelle vorgenommen und die Werte aktualisiert; heutzutage erfolgt die Berechnung live.

Bei Computerspielen ist die Verarbeitung von mehreren Eingaben lange der Normalfall gewesen. Da die Leistung fehlte, um einen würdigen Gegner für menschliche Spieler zu berechnen, musste entweder das Spiel (in Adventurespielen) bzw. die Spielwelt (in Jump’n-Run-Spielen) als Quasi-Gegner fungieren. In anderen Spielen (wie Tennis oder Autorennen) wurde ein menschlicher Gegner benötigt, dieser hatte ein eigenes Eingabegerät. Der Computer nahm dabei die Eingaben zweier Geräte gleichzeitig entgegen. Ohne Eingabepuffer für jedes dieser Geräte wäre das schwer möglich gewesen. Der Computer schaltete schnell hin und her: Eingabepuffer 1 auslesen, Daten verarbeiten, Eingabepuffer 2 auslesen, Daten verarbeiten, Ergebnis berechnen und ausgeben.

C 64 und Amiga 500 besaßen jeweils zwei Eingänge für Joysticks und luden dazu ein, zu zweit zu spielen. Bei Tennis wurden beide Eingaben auf dem selben Bildschirmbereich gleichzeitig dargestellt: als tennisspielende Figuren, zwischen denen der Ball hin- und hergespielt wurde. Bei Autorennen wurde der Bildschirm geteilt: Ein Spieler steuerte das Fahrzeug in der oberen Bildschirmhälfte, der andere das Fahrzeug in der unteren. Doch war nur eine Eingabe nötig, beispielsweise bei einem Jump’n Run (wie „Super Mario“ oder „Gianna Sister“), wurde einer der Eingänge abgeschaltet. Ebenso konnte der Mauszeiger bei Geos oder „Maniac Mansion“ nur mit einem Gerät gesteuert werden.

Heutige Computer lassen den Nutzer entscheiden, wie die Bedienung erfolgen soll. So kann der Mauszeiger gleichzeitig über ein TouchPad (im Laptop) und eine zusätzlich angeschlossene Maus bedient werden. Steuert man an beiden Geräten gleichzeitig, vollführt der Mauszeiger seltsame Figuren, da sich die zwei Eingaben nur auf ein einzelnes Element beziehen und zu einer einzigen Eingabe zusammengerechnet werden müssen.

Zuwachs an Dimensionen

Buchstaben sind eine serielle Angelegenheit. Sie müssen in einer bestimmten Reihenfolge stehen, um Sinn zu erzeugen. Zeilenumbrüche sind nur der Tatsache geschuldet, dass es keine endlosen Zeilen gibt. Mit den Cursortasten wurde der Bildschirm erstmals rudimentär zum zweidimensionalen Raum. Denn der Cursor konnte nicht nur in der Zeile vor- und zurückbewegt werden, sondern auch nach oben oder unten in andere Zeilen – oder, was noch wichtiger ist, auf Elemente außerhalb der Buchstabenfolgen, beispielsweise in ein Menü am oberen oder unteren Bildschirmrand. Wirkliche Zweidimensionalität entstand erst mit der GUI, denn diese trennte zwischen Text, Textcursor und Mauszeiger.

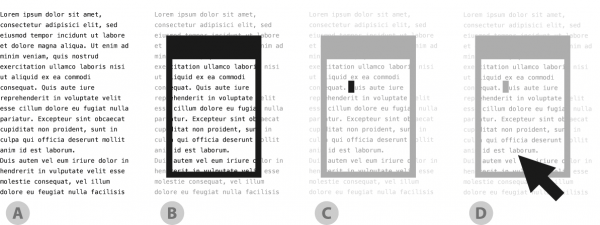

Stark vereinfacht laufen hier fünf Prozesse. Erstens, die Berechnung von irgendwelchen Daten im Hintergrund. Zweitens, die Darstellung der Ergebnisse (A). Drittens, die Einbindung dieser Darstellung in die GUI mit Fenstern, Menüs, etc (B). Viertens, die Abfrage der Textcursor-Platzierung oder Tastatureingaben (C). Fünftens, die Abfrage der Mausaktionen: Bewegen oder Klicken (D). [Abbildung: Autor].

Computer müssen zahlreiche Dinge scheinbar gleichzeitig erledigen, sodass verschiedene Elemente stets rechtzeitig auf dem Bildschirm erscheinen und die Illusion von direkter Manipulierbarkeit entsteht. Computer und Benutzer warten nicht mehr aufeinander, wobei Blinkcursor bzw. [Enter] jeweils den Beginn der Wartephase für einen der Beteiligten signalisierte, während für den anderen eine Wartephase endete. In der GUI-Welt muss der Computer mindestens auf die Mausbewegung immer reagieren, auch wenn er eigentlich vollständig beschäftigt ist.

Bleibt man gedanklich bei dem Ebenenmodell, wie sich der Bildschirm aus Inhalt, GUI-Elementen, Textcursor und Mauszeiger zusammenfügt, so müssen diese Ebenen auch im System abgebildet werden, und die Ergebnisse jeder Ebene werden am Ende zum Bildschirmsignal zusammengefügt. Je häufiger zu einem dieser Prozesse geschaltet wird, desto zuverlässiger wird er erledigt. Daher sorgten die Mac-Programmierer dafür, dass die Maus zuverlässig häufig abgefragt wurde, indem sie den dafür zuständigen Softwareteil sehr dicht an den Betriebssystemkern angliederten. Das führte zu dem kuriosen Effekt, dass bei einem eingefrorenen System der Mauszeiger immer noch auf jede Bewegung reagierte.

Während sich der Textcursor nur im Buchstabenraster bewegen konnte, war der Mauszeiger scheinbar frei und konnte bildpunktgenau gesteuert werden. Während die Eingabe über Tastatur bereits gerasterte Informationen ergibt – der Nutzer muss Eingaben in das Raster des Alphabets einpassen, er kann keine Zeichen eingeben, die auf der Tastatur nicht vorgesehen sind –, erfolgt die Maussteuerung ↑ analog. Daher muss der Computer die Mausbedienung in ein Raster einpassen, für die Darstellung des Zeigers ist es das Raster des Monitors.

Um das Gefühl der direkten Bedienung zu geben und Fehlbedienungen zu vermeiden, werden verschiedene Abweichungen toleriert. Hysterisis beispielsweise verzögert das Menüverschwinden, sodass die Maus kurz abrutschen kann, ohne dass der Nutzer danach von vorn anfangen muss. Doppelklicks sind durch zwei Parameter definiert: Die beiden Klicks müssen innerhalb kurzer Zeit innerhalb eines bestimmten Abstandes auf dem Bildschirm erfolgen. Wird die Maus dazwischen leicht bewegt, gilt das dennoch als Doppelklick, während eine größere Bewegung als zwei einzelne Klicks interpretiert wird. Eine weitere Unterstützung ist die Beschleunigung des Mauszeigers. Bewegt man die Maus in eine bestimmte Richtung, wird der Mauszeiger zunehmend schneller, obwohl sich die Geschwindigkeit der Maus nicht ändert. Durch die Langsamkeit bei kurzen Bewegungen ist exaktes Positionieren möglich, durch die Beschleunigung sind auch große Entfernungen in akzeptabler Schnelligkeit zu überwinden.

Den Übergang von der Welt des Aufeinander-Wartens zur Welt, die mit der Maus erforscht werden will, feiert Steven Johnson anlässlich von Engelbarts Demonstration:

No longerÜbertragung: Nicht länger war [der Bildschirminhalt] ein lebloser, obskurer Schnittpunkt zwischen Nutzer und Mikroprozessor; er war ein eigenständiges Gebilde, eine kulturelle und technologische Errungenschaft. a lifeless, arcane intersection point between user and microprocessor, it was now an autonomous entity, a work of culture as much as technology.

Neben die technische Bedeutung dieser Bedienung gesellt sich die kulturelle. Der Computer war zu einer eigenen Welt geworden, die erforscht werden konnte. Das einstige Raster (Blockbuchstaben) wurde durch ein so feines Raster (Bildpunkte) ersetzt, dass es scheinbar verschwand. Damit sind Computer keine bloßen Rechenknechte mehr, sondern liefern Erfahrungswelten. Die zuverlässige Maus-Steuerung sorgt dafür, dass die Illusion der direkten Manipulierbarkeit aufrechterhalten wird. Dadurch änderte sich auch die Einstellung der Nutzer gegenüber den Computern.

In den 1980ern hieß es noch, dass zum Texteschreiben keine Maus benötigt werde, allenfalls für grafische Arbeiten wurde der Maus eine Existenzberechtigung zugestanden. Solch mit Nachdruck vorgetragene Einschätzung war in den 1990ern nirgends mehr anzutreffen; allenfalls Programmierer lehnen für bestimmte Aufgaben die Mausbedienung ab. Der Mauszeiger steht nicht nur für ↑ „Point’n Click“ und ↑ „Drag \& Drop“, sondern auch für die gefühlte Macht des Nutzers über den Computer. Diese Macht reduzierte die Ehrfurcht vor der Technik, motivierte Abstinenzler zur Nutzung und führte die Nutzer direkter an die Technik.

- Direkte Manipulierbarkeit: Der Mauszeiger reagiert (fast) immer auf Bewegungen, ein Klick ist überall möglich. Damit kann der Nutzer selbst entscheiden, welche Eingaben er wann tätigt und wo er auf seinem Bildschirm arbeiten möchte; dies wird ihm nicht von einer Kommandozeile vorgegeben.

- Kontrolle: Der stets reagierende Mauszeiger signalisiert die Bedeutung der Nutzereingaben, die nicht zugunsten anderer Aufgaben ignoriert werden. Nur wenn tatsächlich keine Eingabe erfolgen kann, wird dies durch einen anders gestalteten Mauszeiger verdeutlicht. Der Nutzer muss nicht auf den Computer warten, sondern behält stets die gefühlte Herrschaft über das System.

- Abstraktion: Vorgänge aus der Realität wie das Wegwerfen von Dokumenten in den Papierkorb werden durch das Ziehen eines Dokument-Icons auf das Papierkorb-Icon abstrakt dargestellt. Die Eingabe eines Befehls zum Löschen wäre die direktere Aktion. Die GUI-Zwischenschicht, die die Nutzeraktionen in Computerbefehle übersetzt, entfernt den Nutzer von der Computertechnik, obwohl er gefühlt dichter dran ist.

- Metapher: Der virtuelle Schreibtisch weist bekannte Objekte und Objekt-Beziehungen auf, sodass technische Vorgänge metaphorisch anschaulich werden. Die Metapher ist dicht genug, um nachvollziehbar zu sein, aber noch nicht so dicht, dass eine Simulation entsteht; auf dem virtuellen Schreibtisch muss ich keine Schreibtischlampe ausrichten oder eine Grünpflanze gießen.

Reagiert der Mauszeiger nicht, werden Eingaben ignoriert, werden unlogische Objekt-Relationen abgebildet oder Objekte ohne sinnvolle Funktion dargestellt – dann bricht die Kontroll-Illusion zusammen. Die Schreibtisch-Metapher ist darauf ausgelegt, dass der Nutzer das Gefühl für Kontrolle bekommt und sich nicht der Technik unterordnet, sondern diese sich seinen Bedürfnissen und Zielen unterzuordnen hat. Der Mauszeiger repräsentiert den Nutzer; wird er trotz Mausbewegung nicht bewegt oder ignoriert Mausklicks, entsteht der Eindruck, dass der Computer den Nutzer ignoriert. Daher kann nicht genügend Aufwand betrieben werden, um die direkte Manipulierbarkeit zu gewährleisten, die Illusion von Kontrolle aufrechtzuerhalten, die Abstraktion korrekt zu programmieren und die Metapher konsequent und logisch zu konzipieren.

Bei der Tastatureingabe gibt es zwei Möglichkeiten. Entweder der Computer kann Eingaben entgegennehmen und tut dies – oder nicht. In der Kommandozeilen-Ära wurden Eingaben ignoriert, wenn der Computer den Blinkcursor noch nicht wieder angezeigt hatte. In der GUI-Ära werden Eingaben ignoriert, wenn kein sinnvoller Ort für die Texteingabe aktiv ist. Was mit Tastatureingaben geschieht, ist also davon abhängig, ob der Computer bereit ist, diese anzunehmen.

Die Macht des Zeigens

Die Mausbedienung kennt das Warten auf die Maschine nicht. Der Mauszeiger wird immer bewegt, ob der Computer das gerade für sinnvoll hält oder nicht. Doch nicht alle Elemente müssen anklickbar sein, meist sind sie dann auch optisch als deaktiv gekennzeichnet. Damit verfügt die Maus über zwei verschiedene Aktionen: Zeigen und Klicken („Point’n Click“). Internetseiten unterscheiden beispielsweise zwischen Zeigen und Klicken. Beim Berühren eines Links mit dem Mauszeiger verändert sich der Mauszeiger, oft wird auch der Link deutlich hervorgehoben, doch erst bei einem Klick wird die Verknüpfung aufgerufen.

Durch diese Unterscheidung zwischen Zeigen und Klicken hat die Maus mehr Potenzial als unsere Hand in der wirklichen Welt. Denn die Bewegung unserer Hand verändert in unserer Welt nichts, erst das Anfassen oder Bewegen. Neben der Maus gibt es andere Bediengeräte, die jeweils andere Implikationen mit sich bringen.

- Trackball: Funktioniert wie eine umgedrehte Maus. Der Mauszeiger wird durch die Drehung eines Balles bewegt, der Klick wird durch separate Taster ausgelöst.

- TrackPad, TouchPad: Der Mauszeiger wird durch Fingerbewegungen auf einer sensitiven Fläche bewegt, Klicks werden durch extra Tasten oder Antippen der Fläche (nach der Positionierung des Zeigers) ausgelöst.

- Joystick: Der Mauszeiger wird mit einem Steuerhebel bewegt, ein Klick wird über separate Tasten ausgelöst.

- Zeichentablett: Eine sensitive Oberfläche reagiert auf die Berührung mit einem speziellen Stift und wertet auch dessen Druck aus. Damit können einerseits Mausbewegung und -klick nachgebildet werden. Man kann aber auch den „Zeigemodus“ deaktivieren. Dann bewirkt das Berühren an einer Stelle des Tabletts auch einen Klick auf der entsprechenden Position auf dem Monitor – ohne dass der Mauszeiger dorthin bewegt werden müsste. Die Tablettfläche entspricht also dem Monitor, ohne dessen Inhalt anzuzeigen, aber nach kurzer Übung trifft man die Ziele auf dem Monitor. Um ein Icon zu bewegen, wird der Stift an der entsprechenden Stelle des Tabletts abgesetzt und dann auf dem Tablett bewegt, dabei wird das Icon mitgenommen. Sobald der Stift das Tablett verlässt, wird das Icon losgelassen.

- Lichtstift: In den 1970ern und 1980ern noch vergleichsweise verbreitet, kann mit dem Lichtstift direkt auf den Monitor gezeigt werden; auch hier fehlt der Zeigemodus, es sind nur Klicks mit anschließendem Bewegen möglich.

- TouchDisplay oder TouchScreen: Konzeptionell eine Kombination aus Zeichentablett (Fläche) mit TouchPad (Fingerberührung) und Monitor (Anzeige): Mit einem speziellen Stift oder dem Finger wird direkt auf das Display getippt. Auch hier gibt es keinen Zeigemodus.

- MultiTouch: Erweiterung des TouchDisplays. Das Gerät kann mehrere gleichzeitige Berührungen erkennen und verarbeiten. Diese dienen jedoch nicht dem Zeiger, sondern lösen spezielle Aktionen aus, beispielsweise bewirken zwei auseinandergezogene Finger einen Zoom. Theoretisch können so auch mehrere Aktionen gleichzeitig vollführt werden: eine Bewegung verschiebt ein Icon, während eine andere die eMails sortiert.

Die Maus ist im Vergleich zu anderen Bedienungsgeräten vergleichsweise billig zu produzieren und etablierte sich deshalb als Standard-Gerät. Bei Zeichentablett, Lichtstift und ↑ TouchDisplay fällt der fehlende Zeigemodus auf. Diese Eingabemöglichkeiten dienen der unittelbaren Manipulation – ohne vermittelnden Mauszeiger. Konzeptionell ist der Mauszeiger nur ein zusätzliches Objekt, das zum Einsatz kommt, wenn Objekte auf dem Bildschirm mit dem Bediengerät nicht direkt angeklickt werden können.

In der Ideal-GUI wäre der Zeigemodus nie nötig. Denn der Zeiger wird ja nur benötigt, damit man bei einem Bewegungsgerät – wie Maus oder Joystick – eben sieht, wo ein Klick erfolgen wird. Doch Internetseiten und einige Programme unterscheiden zwischen Zeigen und Klicken. Damit ist kein problemloser Mausverzicht möglich, denn der Zeiger wird benötigt, um bestimmte Aktionen ausführen zu können. Beispielsweise zeigen Schaltflächen, wenn der Mauszeiger über ihnen weilt, eine kurze Information an, was ein Klick bewirken würde – diese Nutzer-Unterstützung fehlt bei einem TouchDisplay oder Lichtstift.

Verzicht aufs Zeigen

Der mit dem iPhone einsetzende Touch-Screen-Hype bewirkt zwei Dinge: Verzicht auf den Mauszeiger und Wegfall des Zeigens als eigenständige Bedienaktion sowie die Hinwendung zu einer direkteren Manipulation. Ein normales Computersystem kann nicht einfach via TouchDisplay bedient werden, denn als Nebenwirkung des Vierteljahrhunderts Maus-Bedienung wurde das Zeigen als eigenständige Bedienaktion etabliert. Auf diese muss nun wieder verzichtet werden – für die Nutzer ist dies einfach, für die Programmierer bedeutet es jedoch ein Umdenken.

Auf einem TouchDisplay manipuliert der Nutzer den Bildschirminhalt tatsächlich direkt. Er muss beispielsweise nicht mehr einen Scrollbalken verschieben, sondern tippt einfach auf den zu scrollenden Bereich und schiebt ihn nach oben, unten, links oder rechts. Direkter kann Scrollen nicht sein. Mit dem Mauszeiger würde die gleiche Aktion dazu führen, dass ein Bereich des eigentlich zu scrollenden Bereichs markiert würde; es sei denn, man verwendet den in einigen Programmen vorhandenen Verschiebebefehl, wobei der Mauszeiger dann als Hand dargestellt wird. Einige Programme, wie die PDF-Anzeige, bieten für den Mauszeiger ein Umschalten zwischen zwei Modi: Bereich markieren und Bereich verschieben.

Was bei der Mausbedienung nur eine in bestimmten Umständen wählbare Zusatzfunktion ist – das direkte Verschieben von Fensterinhalten mittels Maus-Hand – ist bei der Touch-Bedienung aber der Normalfall. Zumindest stellt es sich als Normalfall dar, während die Bearbeitung von Inhalten, wozu das Markieren benötigt wird, auf Touch-Geräten die aufwändigere Aktion ist. Meist ist zur Auslösung eine längere Berührung nötig, während eine kurze Berührung mit anschließendem Ziehen den Bildschirminhalt verschiebt. Das Verschieben wird in der Mauszeiger-Welt dagegen gewöhnlich über Scrollbalken oder ein Mausrad erledigt.

Ein Gerät mit TouchDisplay verzichtet oft auf eine Tastatur. Die einzige Bedienmöglichkeit sind Berührungen auf dem Bildschirm; eine oder wenige Tasten außerhalb des Bildschirms rufen Spezialfunktionen auf, beispielsweise führt der „Home“-Button auf dem iPhone stets direkt zum Startbildschirm. PCs sind dermaßen komplex mit ihren multitaskenden Programmen, ihren vielfältigen Möglichkeiten und komplexen Dateisystemen, dass für eine effektive Bedienung die Kombination aus Maus und Tastatur sinnvoll ist. Andersherum formuliert: Da zahlreiche Bedienelemente (Mauszeiger, Tastaturbefehle, Cursortasten, etc.) fehlen oder aufgrund der Größe mittels Tippen unbedienbar wären, muss ein System für TouchDisplay neu designt werden. Die Beschränkung auf Antippen als einzige Bedienweise – ggf. kombiniert mit MultiTouch-Gesten – erfordert einen anderen Zugang zum Computer.

Auf einem Bildschirm befindet sich ein Mauszeiger, an den Computer ist nur eine Maus angeschlossen. Gibt es mehrere Eingabegeräte, wird deren Bewegung vom einzigen Mauszeiger wiedergegeben. Doch bei Touch-Bedienung gelten diese Beschränkungen nicht mehr, potenziell kann es jeder Vorbeikommende bedienen, da er das Eingabegerät (seine Finger) dabei hat. Bedienen mehrere Personen einen Computer, müssen mehrere – voneinander unabhängige – Bildschirmbereiche gleichzeitig aktiv sein können. Die Technik ist zwar schnell genug, um mehrere Nutzer gleichzeitig arbeiten zu lassen, doch die bisherige Metapher und die Fensterlogik lassen konzeptionell keine Mehr-Personen-Bedienung zu.

Wie bei jeder Technologie erweist sich die Nützlichkeit von Multi-Touch erst im Umgang mit Fehlern. Würden mehrere Eingaben einander widersprüchliche Resultate erzeugen (beispielsweise Foto löschen und gleichzeitig Foto archivieren), muss das in sinnvoller Weise abgefangen werden. Will ein Nutzer einen anderen ärgern oder blockieren, müssen geeignete Wege gefunden werden, damit keine Daten zerstört werden. Bei der Ein-Personen-Nutzung von MultiTouch-Geräten gibt es diese Probleme nicht, sondern die bestehenden Metaphern können erweitert und ausgebaut werden. Es sind nur andere Eingaben möglich, um ein Ziel zu erreichen, eben beispielsweise Finger auseinanderspreizen statt „Zoom“ anklicken.

Die Mehr-Personen-Bedienung kann nur in einigen wenigen Fällen problemlos funktionieren, vorwiegend sind das Anwendungen, bei denen auch in der Realität das koordinierte gemeinsame Arbeiten nötig ist. In der Realität sind manche Konflikte schon schwer zu lösen. Diese würden automatisch in die digitale Welt getragen und die Arbeit erschweren, wenn mehrere Benutzer sich einen Bildschirm teilen könnten bzw. müssten und gleichzeitig Zugriff auf dieselben Daten haben.

Tastatur

| Eingabe | Anwendung | Problem | |

|---|---|---|---|

| Tastatur | seriell | Text, Tastenkürzel (Befehle) | Bewegung nur im Raster |

| Joystick | Angabe der Richtung | Bewegen von Elementen auf dem Bildschirm in angegebener Richtung | keine Bewegung in der Fläche |

| Maus | Bewegung | Bewegen von Elementen auf dem Bildschirm analog der Mausbewegung | benötigt Element, das bewegt wird |

| Touch | Tippen und Ziehen | direkte Manipulation | kein Element, das den Nutzer auf dem Bildschirm vertritt |

| Multi-Touch | mehrere Eingaben gleichzeitig | Aktionen in der Fläche (Zoom, Rotation) und Sonderfunktionen (vordefinierte Gesten) | Umgang mit widersprüchlichen Parallel-Eingaben |

| Balance/ Neigung | Winkel, in dem das Gerät gehalten wird | Geschicklichkeitsspiele | keine Punkteingabe möglich |

Die Auswertung der Gerätelage (Balance/Neigung) integriert die direkte Manipulation noch stärker. Damit wird das Gerät selbst zur Eingabe, und der Bildschirminhalt je nach Haltung gedreht oder angepasst. So hält der Nutzer beim iPhone und iPad das Internet wortwörtlich in der Hand, und dieses reagiert darauf, wie er es hält. Was nach Spielerei klingt, bringt letztlich dem Nutzer ein stärkeres Kontrollgefühl und unterstreicht, dass sich die Technik dem Nutzer anpasst und nicht dieser dem Gerät.

Überblick über „Der Apple-Faktor, Band I“:

1. Einleitung

2. Die Anfänge

3. Von der Taste zum Touch

4. Von der Anweisung zum Klick

5. Virtueller Schreibtisch

6. Vom Buchstaben zur Transparenz

7. Vom Einzelplatz zum Netz

8. Von der Philosophie zum Kompromiss

9. Die wunderbare Welt der Software

10. Zum Ende: Versuch eines Vergleichs zwischen Mac OS X und Windows Sieben

Epilog: Eine neue Zeit

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

Pingback: Der Apple-Faktor: Einleitung | zanjero.de

Pingback: Der Apple-Faktor, Band I | zanjero.de

Pingback: Der Apple-Faktor: Die Anfänge | zanjero.de